Appunti di sviluppo di una procedura software per l’ analisi di Pushover

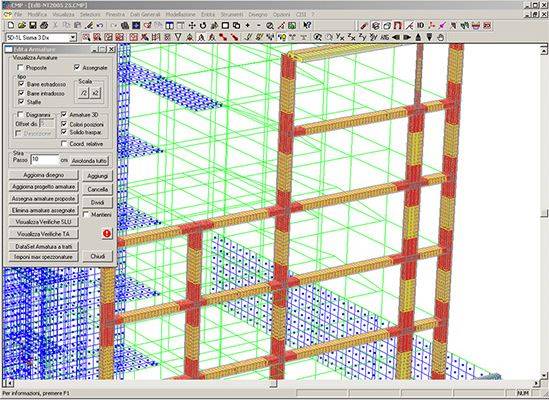

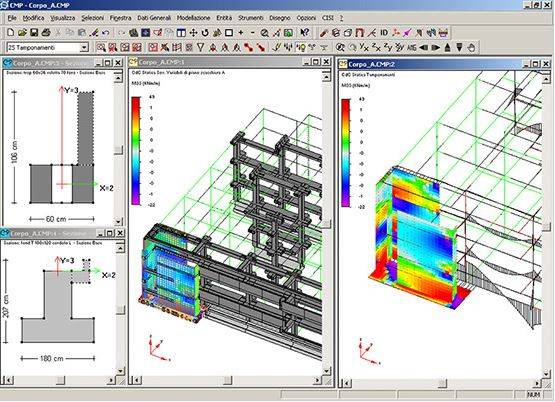

principali problematiche ed incertezze incontrate dai progettisti che si sono occupati dello sviluppo della corrispondente procedura software all’interno del codice di calcolo CMP

NAMIRIAL

Il presente testo non vuole essere né una trattazione teorica, né un lezione sul tema della valutazione di vulnerabilità sismica svolta mediante un’analisi di Pushover, ma solo ed esclusivamente la condivisione delle considerazioni svolte e delle principali problematiche ed incertezze incontrate dai progettisti che si sono occupati dello sviluppo della corrispondente procedura software all’interno del codice di calcolo CMP; considerazioni, problematiche e incertezze che non hanno sempre trovato soluzioni univoche e che quindi potenzialmente presenti in qualsiasi software, possono risultare comunque di interesse per tutti coloro che affrontano una progettazione o una valutazione di vulnerabilità affidandosi a tale metodo di calcolo.

Il presente testo non vuole essere né una trattazione teorica, né un lezione sul tema della valutazione di vulnerabilità sismica svolta mediante un’analisi di Pushover, ma solo ed esclusivamente la condivisione delle considerazioni svolte e delle principali problematiche ed incertezze incontrate dai progettisti che si sono occupati dello sviluppo della corrispondente procedura software all’interno del codice di calcolo CMP; considerazioni, problematiche e incertezze che non hanno sempre trovato soluzioni univoche e che quindi potenzialmente presenti in qualsiasi software, possono risultare comunque di interesse per tutti coloro che affrontano una progettazione o una valutazione di vulnerabilità affidandosi a tale metodo di calcolo.

Sappiamo tutti infatti quanto purtroppo da un lato l’adozione di metodologie di calcolo sempre più sofisticate (e l’analisi statica non lineare di “Pushover” è sicuramente una di queste) e dall’altro l’inevitabile necessità di utilizzare strumenti di calcolo automatici, che a volte per motivi sicuramente non nobili tendono a semplificare al massimo i problemi all’utente (il progettista) al solo scopo di ridurre al minimo tempi e costi di sviluppo di una progettazione, portano frequentemente ad utilizzare gli stessi sistemi informatici in modo inconsapevole, perdendo di vista le innumerevoli approssimazioni, convenzioni, ipotesi, limiti di applicabilità all’interno dei quali e solo all’interno dei quali i risultati ottenuti hanno un significato.  Dando per scontata la conoscenza generale del metodo, del suo significato, della sua operatività, sottolineiamo che le norme individuano tale metodo come quello maggiormente indicato per l’analisi di edifici esistenti, nonostante molti testi affermino che l’analisi statica non lineare, per come è formulata, è tanto più affidabile quanto più l’edificio risulta regolare. La stessa circolare asserisce che il metodo è utilizzabile solo per costruzioni il cui comportamento sotto sisma sia governato da un modo di vibrare naturale principale caratterizzato da una significativa partecipazione di massa. Negli edifici esistenti non sempre questa condizione è soddisfatta.

Dando per scontata la conoscenza generale del metodo, del suo significato, della sua operatività, sottolineiamo che le norme individuano tale metodo come quello maggiormente indicato per l’analisi di edifici esistenti, nonostante molti testi affermino che l’analisi statica non lineare, per come è formulata, è tanto più affidabile quanto più l’edificio risulta regolare. La stessa circolare asserisce che il metodo è utilizzabile solo per costruzioni il cui comportamento sotto sisma sia governato da un modo di vibrare naturale principale caratterizzato da una significativa partecipazione di massa. Negli edifici esistenti non sempre questa condizione è soddisfatta.

Seguiamo allora operativamente le fasi di applicazione del metodo e le conseguenti scelte che ogni progettista, al fine di sapere cosa sta facendo, dovrebbe poter fare; qualora non gli sia consentito dovrebbe quantomeno poter conoscere quelle fatte automaticamente dal software al fine di giudicarne l’eventuale incongruenza con le condizioni reali.

FASE DI MODELLAZIONE E ANALISI

- Modello a fibre o a plasticità concentrata: l’analisi di pushover si basa prevalentemente sulla modellazione delle cerniere plastiche flessionali negli elementi beam. Le metodologie normalmente proposte dai software prevedono la modellazione delle cerniere plastiche con due tecniche: o mediante la tecnica delle cerniere concentrate, nelle quali il funzionamento non lineare della cerniera è rappresentato da una molla non lineare, concentrata in un punto ben definito del modello di calcolo, con funzionamento descritto da diagramma Momento-Rotazione; o mediante la tecnica della plasticità diffusa nella quale le sezioni degli elementi sono discretizzate mediante una suddivisione in fibre e quindi la non linearità di comportamento risiede nella definizione dei legami costitutivi dei materiali componenti.

- Modello a plasticità concentrata: è probabilmente il più diffuso; ha il pregio di essere computazionalmente più rapido, ma ha almeno tre problemi significativi per il progettista. Il primo è la definizione delle caratteristiche della cerniera e quindi della curva Momento-Rotazione, a volte derivata da un diagramma Momento-Curvatura, per la quale esistono in letteratura diverse funzioni per condizioni usuali ma che in realtà possono modificarsi significativamente al variare delle geometrie, delle percentuali di armatura, delle tipologie di materiale; il secondo riguarda ancora le curve Momento-Rotazione nel momento in cui, a parità delle altre condizioni, la curva cambierebbe al variare dello stato di sollecitazione e in particolare della presenza di sforzo normale che come prevedibile può subire significative modificazioni nel corso dell’analisi; il terzo riguarda il posizionamento delle cerniere che normalmente sono inserite in corrispondenza delle estremità delle aste convergenti alle intersezioni travi-pilastri, quando può frequentemente presentarsi il caso in cui la composizione degli effetti, conseguenti ai carichi gravitazionali ed orizzontali, generi i punti di massima sollecitazione flessionale in campata dove il modello non prevede possibile formazione di cerniera plastica.

- Modello a plasticità diffusa: meno presente del primo, in questo caso il progettista deve solo occuparsi di definire il corretto legame costitutivo dei materiali e quindi appare più semplice risolvendo di fatto tutte le problematiche rilevate per la plasticità concentrata. In realtà anche questa tecnica presenta i propri problemi: il primo riguarda la possibile presenza di limitazioni alla geometria delle sezioni e alla corrispondente disposizione di armatura che potrebbero non essere generiche costringendo quindi il progettista a utilizzare sezioni differenti da quelle reali svolgendo opportune valutazioni di equivalenza. Il secondo riguarda il maggiore onere computazionale, decisamente superiore al caso della plasticità concentrata, con conseguenti difficoltà a svolgere ed eventualmente ripetere molteplici analisi su modelli anche non troppo complessi. Il terzo riguarda la possibilità, per ridurre l’onere computazionale di cui sopra di limitare le zone degli elementi strutturali soggetti a modellazione a fibre nel qual caso si ricade in una modellazione di fatto similare a quella utilizzata per la plasticità concentrata e cioè perdendo la possibilità di intercettare eventuali plasticizzazioni in campata.

Ulteriore problema del modello a fibre è costituito dalla possibile nascita di ingenti sforzi normali negli elementi beam: la parzializzazione della sezione può generare un allungamento della fibra baricentrica che, se impedito, ad esempio da un piano rigido, determina la conseguente inevitabile nascita di sforzo normale per assicurare la congruenza degli spostamenti. In tal caso o il software o il progettista devono intervenire svincolando ad esempio un estremità nei riguardi dello sforzo normale. Si fa notare il fatto che la presenza di uno sforzo normale in realtà inesistente può falsare completamente i risultati dell’analisi e delle verifiche, inficiando la validità della conseguente progettazione.

- La tipologia delle cerniere plastiche: tale modellazione è corretta solo se nella realtà i meccanismi fragili, dovuti ad esempio al taglio, non anticipano quelli duttili conseguenti al raggiungimento delle rotazioni limite; in tal caso infatti i secondi non si attivano per nulla e tutta l’analisi successiva al punto di attivazione dei meccanismi fragili potrebbe risultare significativamente falsata. Se il software consente di gestire contemporaneamente i due possibili meccanismi (cerniere flessionali e cerniere a taglio) il problema non si pone; se il software implementa si entrambe le situazioni, ma non contemporaneamente, occorre che il progettista possa scegliere, a seguito di valutazioni preliminari o iterazioni successive, dove privilegiare le une rispetto alle altre e viceversa. Se il software consente l’utilizzo di sole cerniere flessionali occorre che il progettista sulla base delle stesse valutazioni o iterazioni successive decida eventualmente dove fermare la curva da considerare in quanto oltre i risultati possono avere perso di significato.

- La definizione delle distribuzioni di forze orizzontali:

- Normalmente distribuzioni simili a quelle per analisi statica equivalente (§ 7.3.3.2 – NTC 2008), o derivate da distribuzioni uniformi di accelerazioni o basate sul primo modo di vibrare: tutti i software le prevedono calcolate in automatico;

- se queste distribuzioni non fossero significative occorre potere inserire distribuzioni derivate da combinazioni SRSS (combinazioni modali) o di altro tipo: già meno software lo consentono;

- in ogni caso sarebbe positivo avere la possibilità di inserire al limite distribuzioni di tipo assolutamente generico figlie di opportune considerazioni del progettista.

- La scelta del punto di controllo: modificare il punto di controllo può far cambiare significativamente i risultati se la struttura presenta irregolarità in pianta e soprattutto in altezza: occorre poter definire per ogni analisi un punto differente potendolo eventualmente modificare e conseguentemente stimarne gli effetti.

- Il punto terminale della curva: può essere coincidente con il massimo imposto dal progettista o essere inferiore nel caso in cui l’analisi abbia evidenziato il collasso prima o comunque si siano presentati problemi di convergenza numerica che non abbiano consentito di raggiungere il massimo richiesto. Può poi esserci il caso in cui problemi di collasso fragile a taglio possano rendere non significativa parte della curva.

FASE DI GESTIONE DELLA CURVA DI CAPACITA’

- Passaggio da MGDL a SGDL: al termine dell’analisi ci viene fornita la “curva di capacità” ( Taglio alla base “Vb” – Spostamento del punto di controllo “dc” ) del sistema analizzato a Multi gradi di libertà “MGDL”. Il passaggio alla corrispondente curva del sistema ad un Singolo grado di libertà (SGDL) avviene scalando la prima curva mediante il coefficiente di partecipazione del primo modo di vibrare.

- Il calcolo di tale coefficiente si effettua normalmente secondo una formula, riportata in normativa, nella quale per la NTC2008 il vettore spostamento è il vettore degli spostamenti del primo modo di vibrare normalizzato allo spostamento del punto di controllo per qualunque sistema di forze applicato. Altre norme considerano invece il vettore spostamento come quello congruente alla distribuzione di forze adottata, per cui ad esempio la norma americana prevede che per una distribuzione di forze proporzionale alle masse il vettore spostamento sia coincidente con l’unità. Il software in generale dovrebbe consentire di intervenire nella definizione di questo vettore spostamento.

- Il coefficiente di partecipazione deve essere esplicitato dal software per potere giudicare la correttezza della scelta del punto di controllo. Per strutture significativamente non regolari in altezza un eventuale valore inferiore a 1 è significativo di una scelta errata e richiede la sua ridefinizione.

- Dove far finire la curva di capacità da considerare: la definizione del sistema bilineare avviene valutando l’equivalenza delle aree sottese da due curve, quella di capacita del sistema SGDL e quella da trovare, nel tratto compreso tra l’origine e un punto terminale che non è univocamente definito. Infatti la norma parla del punto nel quale il Taglio alla base scende all’85% di quello massimo ma le curve ottenute spesso non assomigliano a quella tipica di norma; si può presentare il caso in cui la curva non scenda a quel valore, altre situazioni che possono far scegliere un punto diverso. È inoltre giusto utilizzare una curva di capacità che si estende di molto oltre le domande in spostamento che la pericolosità sismica del sito richiede? In ogni caso si presenta il problema di decidere quale sia l’ultimo punto della curva da considerare e il software dovrebbe consentire di intervenire in tal senso.

FASE DI VERIFICA DELLA STRUTTURA

Ottenute le configurazioni deformate ai diversi step di analisi e in particolare agli step corrispondenti alle domande di spostamento ricavate nella precedente fase, si avvia la fase di verifica consistente nel controllo di congruenza delle deformazioni per gli elementi duttili e di resistenza per gli elementi fragili.

- Definizione della Luce di Taglio: questo parametro, la cui variazione incide significativamente sul risultato delle verifiche può essere determinato con modalità anche molto differenti. Il valore della luce di taglio Lv viene definito come la distanza tra la sezione di estremità, dove viene svolta la verifica, e la sezione di momento nullo, a distanza pari a M/V; in caso di carichi trasversali sull’asta la distanza con la sezione di momento nullo e M/V non coincidono. Normalmente nei software sono implementate diverse possibilità, tra cui anche un criterio semplificato spesso utilizzato nei casi di edifici a telaio molto regolari:

a) M/V: vengono valutate le due sollecitazioni all’estremità dell’asta e viene valutato il loro rapporto;

b) M=0: viene ricercato a partire dall’estremità soggetta a verifica il primo punto in cui il momento flettente si annulla nel piano di verifica e misurata la distanza;

c) viene calcolata la metà della luce della campata nel piano di verifica.

Poiché ciascun metodo ha un proprio campo di validità (e non è nemmeno assicurato che per questa via si coprano tutti i casi possibili) il software dovrebbe consentire la scelta, anche differenziata per elementi strutturali differenti, o quanto meno, rendere noto il metodo applicato.

- Presenza di flessione deviata: normalmente si agisce nei due piani di flessione principale dell’asta; volendo applicare le indicazioni di norma in caso di pressoflessione deviata sarebbe difficile definire un punto di momento nullo o un rapporto tra sforzo di taglio e momento flettente che possono agire in piani differenti.

Si potrebbero citare altri casi.

In conclusione: metodi fortemente dipendenti da innumerevoli parametri e da una applicazione convenzionale di tecniche numeriche alle quali non sempre corrisponde un fenomeno fisico facilmente comprensibile.

Poca chiarezza normativa su come gestire le infinite sfaccettature che si possono presentare nella realtà e quindi potenziale possibilità di applicazione del metodo in condizioni non conformi.

Dato quindi per assodato che per svolgere analisi di questo tipo sia necessario un software e per scontato che il progettista possieda una buona conoscenza del metodo e soprattutto delle sue approssimazioni e dei suoi limiti di applicazione, da quanto detto dovrebbe scaturire inevitabilmente che il software debba essere il più flessibile e intellegibile possibile e il progettista debba essere a conoscenza di come il proprio software affronti e gestisca le diverse problematiche possibili perché solo dalla possibilità di sapere cosa consegue al variare dei parametri incerti può nascere la capacità di giudicare l’attendibilità dei risultati ottenuti, attraverso quel giudizio motivato che giustamente la normativa impone. Questa è da sempre la filosofia di sviluppo del codice di calcolo strutturale CMP e, anche se con grande difficoltà, a maggior ragione lo è stata nell’affrontare una problematica estremamente complessa quale quella in oggetto.

Maggiori info sul software CMP Analisi Strutturale

http://www.edilizianamirial.it/software-calcolo-strutturale.asp