Criteri di progettazione antisismica: è giunto il momento di ripensarli

INTRODUZIONE

I recenti eventi sismici, che hanno interessato il Centro Italia a partire dal 24 agosto 2016, hanno ancora una volta messo in evidenza la scarsa qualità del costruito in Italia e portato all’attenzione dell’opinione pubblica la necessità di avviare un progetto di miglioramento delle costruzioni su tutto il territorio nazionale.

Gli effetti osservati al suolo e sulle strutture mettono anche in discussione alcuni “dogmi” che influiscono sui criteri di progettazione antisismica e che vanno discussi prima di avviare la ricostruzione, spendendo tempo e fondi in fase di programmazione e progettazione, al fine di “fare bene” nel “tempo tecnico necessario”, evitando gli errori del passato.

Nel presente articolo si presentano alcune problematiche relative all’azione sismica di progetto e al comportamento delle strutture e si suggeriscono alcune soluzioni, con l’obiettivo di aprire la discussione tra gli addetti ai lavori e di stimolare altre proposte.

DEFINIZIONE DELL’INPUT SISMICO DI PROGETTO

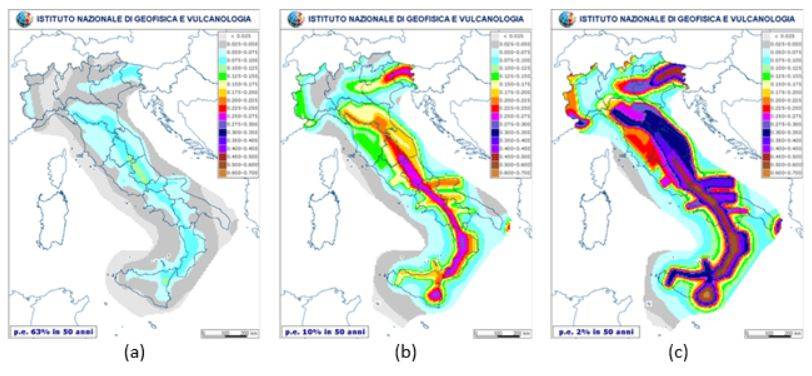

Un buon progetto inizia con una dettagliata analisi delle azioni e, tra queste, in Italia c’è sempre l’azione sismica. Al riguardo, le norme fanno riferimento alle mappe di pericolosità sismica messe a punto dall’INGV, definite su una maglia di lato pari a circa 5.5 km sul territorio italiano e espresse in termini di massima accelerazione orizzontale su suolo rigido PGAA; ciascuna di esse è relativa a una probabilità di superamento PNRC in 50 anni (Fig. 1).

Perché si fa riferimento a un periodo di 50 anni? La risposta che normalmente si fornisce è che 50 anni è considerato un congruo valore della vita utile di una costruzione, ma è probabilmente una giustificazione trovata a posteriori; la vita utile delle nostre costruzioni, infatti, è ben maggiore, specie per gli edifici residenziali. Si tratta comunque di un valore convenzionale, che va sovrapposto ai valori delle probabilità di superamento PNRC, per i quali la scelta deve tener conto della conoscenza della storia sismica, certamente limitata nel tempo e incompleta. Le informazioni disponibili, infatti, diventano sempre meno affidabili andando indietro nel tempo; inoltre, eventi accaduti in aree non abitate, o non di interesse, non sono stati registrati e tramandati; pertanto è ovvia una mancanza di informazioni, soprattutto per gli eventi più violenti e meno frequenti. Le mappe di pericolosità cercano di sopperire alle incertezze di varia natura con dei congrui coefficienti correttivi di sicurezza.

Fig. 1 – Mappe di pericolosità sismica relative a probabilità di superamento del (a) 63%, (b) 10%, (c) 2% in 50 anni (fonte INGV).

Tenendo conto di quanto detto, possiamo essere sicuri che i valori di accelerazione forniti dalla mappa relativa alla probabilità di superamento del 2% in 50 anni, valore minimo contemplato dalle mappe dell’INGV, siano non minori di quelli massimi possibili al sito?

Al riguardo è utile il confronto con i valori di accelerazione massima rappresentati nella mappa di figura 2, ottenuti con un approccio diverso, definito dagli autori neo-deterministico (Panza et al., 2001). Come si evince dalla figura 3, i valori ottenuti con la metodologia probabilistica (PGA) sono quasi ovunque maggiori di quelli ottenuti con la metodologia neo-deterministica, a volte anche esageratamente; il contrario accade, però, dove i valori delle accelerazioni sono maggiori, ossia nelle aree a maggiore pericolosità sismica (DGA, Zuccolo et al., 2011).

Fig. 2 –Mappa di pericolosità ottenuta col metodo neo-deterministico (Panza et al., 2001).

Fig. 3 – Confronto tra i valori di accelerazione PGA e DGA (Zuccolo et al., 2011).

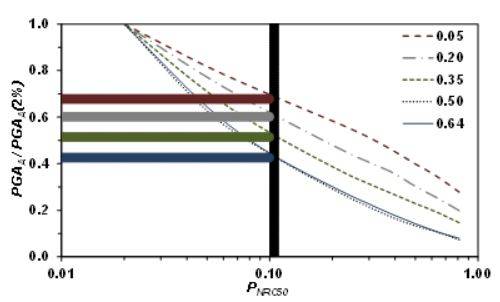

Le norme, però, non richiedono di progettare con i valori dell’accelerazione relativi alla probabilità di superamento del 2% in 50 anni, bensì con quelli del 10%. La relazione tra i due è rappresentata in figura 4 per tutti i punti della maglia sul territorio italiano: in media i valori della mappa del 10% sono poco più della metà di quelli della mappa del 2% e i valori minori (fino a poco più del 40%) si hanno nei siti a maggiore pericolosità sismica, come mostrato nella figura 5, dove le curve riportate, tutte normalizzate rispetto al proprio valore relativo alla probabilità di superamento del 2%, sono relative a siti caratterizzati da diversi valori dell’accelerazione orizzontale con PNRC=2%, indicati in legenda.

Fig. 4 – Coppie di valori di PGAA relativi a PNRC=2% e PNRC=10% nei punti della maglia del territorio italiano.

Fig. 5 – Accelerazione su suolo rigido in funzione della probabilità di superamento in 50 anni, in siti caratterizzati da diversi valori di PGAA per PNRC=2% (curve normalizzate rispetto ai valori con PNRC=2%).

Vanno fatte due osservazioni.

La prima riguarda le nostre conoscenze sulla pericolosità di base, che vengono sempre aggiornate con altri dati a seguito di nuovi studi e nuovi eventi. Un vero e definitivo passo in avanti potrebbe farsi mediante studi di sismica a riflessione, che consentirebbero una mappatura del sottosuolo nazionale per qualche decina di km di profondità (10-20 km) con l’obiettivo di definire i massimi eventi possibili nelle varie aree (Doglioni et al. 2015, Petricca et al. 2015). Si tratta di studi purtroppo molto costosi, ma da prendere in considerazione per affrontare compiutamente la questione sismica, cominciando con le aree a maggiore pericolosità e, soprattutto, laddove lo Stato si sta preparando a impegnare grosse risorse per la ricostruzione, rispetto alle quali i costi necessari per un’adeguata conoscenza sarebbero comunque esigui e ampiamente giustificati.

La seconda osservazione è che la pericolosità sismica di base va integrata con studi di microzonazione sismica. Infatti, lo scuotimento sismico può subire notevoli variazioni in superficie per effetti locali, in termini di valori di picco, durata e contenuto in frequenza, e assumere valori molto diversi a brevi distanze. Al riguardo, gli studi sono già avviati in gran parte del territorio nazionale e potrebbero essere terminati nel giro di pochi anni.

In definitiva, nella progettazione delle strutture si assume un’azione sismica molto minore di quella massima che potrebbe verificarsi al sito, senza alcuna garanzia in caso di evento più gravoso di quello di progetto. Appare ovvio che bisognerebbe superare questo limite, assumendo come azione sismica di progetto la massima accelerazione orizzontale al sito, ossia quella relativa alla minima probabilità di superamento (seguendo l’approccio probabilistico) o quella relativa al massimo evento credibile (seguendo l’approccio deterministico).

IL COMPORTAMENTO DELLE STRUTTURE

Che cosa accade in occasione di un evento pari o superiore a quello di progetto? All’azione sismica di progetto, che come detto è ben minore di quella massima che potrebbe verificarsi, corrisponde lo stato limite ultimo (di salvaguardia della vita) della struttura; quindi, nominalmente la struttura non ha ulteriori riserve e, di conseguenza, nella sua vita potrà sopportare al più un evento pari a quello di progetto. In occasione di tale evento, infatti, la struttura potrebbe danneggiarsi tanto da dover essere demolita o richiedere costi di riparazione esorbitanti. Inoltre, non abbiamo alcuna garanzia sul comportamento della struttura in occasione di eventi più gravosi.

Perché non si progettano strutture in grado di sopportare i terremoti senza subire danni? La risposta che viene data, e che convinceva tutti almeno fino a qualche decennio fa, è che non si progettano strutture in grado di sopportare un sisma violento in campo elastico per motivi economici e architettonici: dovremmo realizzare dei bunker costosi e poco funzionali. Allora ci si affida alla duttilità, che deve essere garantita attraverso idonee scelte progettuali e dettagli costruttivi, con l’obiettivo di realizzare strutture che “danneggiandosi in modo controllato” siano in grado di dissipare energia e di salvaguardare la vita, scongiurando il collasso.

Tale principio oggi non è più accettabile, perché economicamente non sostenibile. Basti pensare ai costi di ricostruzione sostenuti a seguito dei vari eventi sismici degli ultimi 50 anni, alle strutture strategiche, che devono restare operative durante e dopo il sisma, e agli impianti a rischio d’incidente rilevante, che devono rispettare stringenti requisiti di sicurezza.

E allora? Innanzitutto non è vero che non sia possibile, per motivi economici e architettonici, progettare strutture in grado di sopportare il sisma in campo elastico. In buona parte del territorio nazionale, infatti, le massime azioni sismiche non sono tanto severe da scoraggiare o rendere addirittura impossibile la progettazione in campo elastico. Inoltre, laddove ciò non fosse possibile per motivi economici, si potrebbe comunque progettare in campo elastico limitando l’altezza degli edifici o ricorrendo a moderni sistemi antisismici, come l’isolamento sismico alla base: queste non devono necessariamente essere esplicite prescrizioni bensì scelte opportune e convenienti, sia dal punto di vista architettonico che economico, per rispettare le norme.

Una soluzione intermedia potrebbe essere quella di progettare allo stato limite ultimo per l’evento con probabilità di superamento del 2% o per il massimo evento credibile, al fine di garantire la salvaguardia della vita anche per gli eventi massimi, e di assumere per lo stato limite di danno un valore dell’accelerazione sismica il più alto possibile, da fissare per le varie tipologie costruttive sulla base di considerazioni strutturali, funzionali e economiche. Così facendo si ridurrebbe la domanda di duttilità a valori minimi (

[...] CONTINUA LA LETTURA NEL PDF